Wien. Künstliche Intelligenz war bislang vor allem ein Antwortsystem. Sie schrieb Texte, fasste Inhalte zusammen, half beim Programmieren oder Recherchieren. Immer aber wartete sie auf den Befehl eines Menschen. OpenClaw verschiebt diesen Grundmechanismus. Das System versteht KI nicht mehr als reaktives Werkzeug, sondern als handelnden Agenten. Gemeint ist das nicht metaphorisch, sondern technisch präzise: OpenClaw läuft lokal auf einem Rechner, dauerhaft im Hintergrund, mit klar definierten Rechten. Die KI ist kein ferner Cloud-Dienst, sondern ein Prozess auf dem eigenen System, der Programme starten, Dateien verändern, Befehle ausführen und mit Diensten kommunizieren kann.

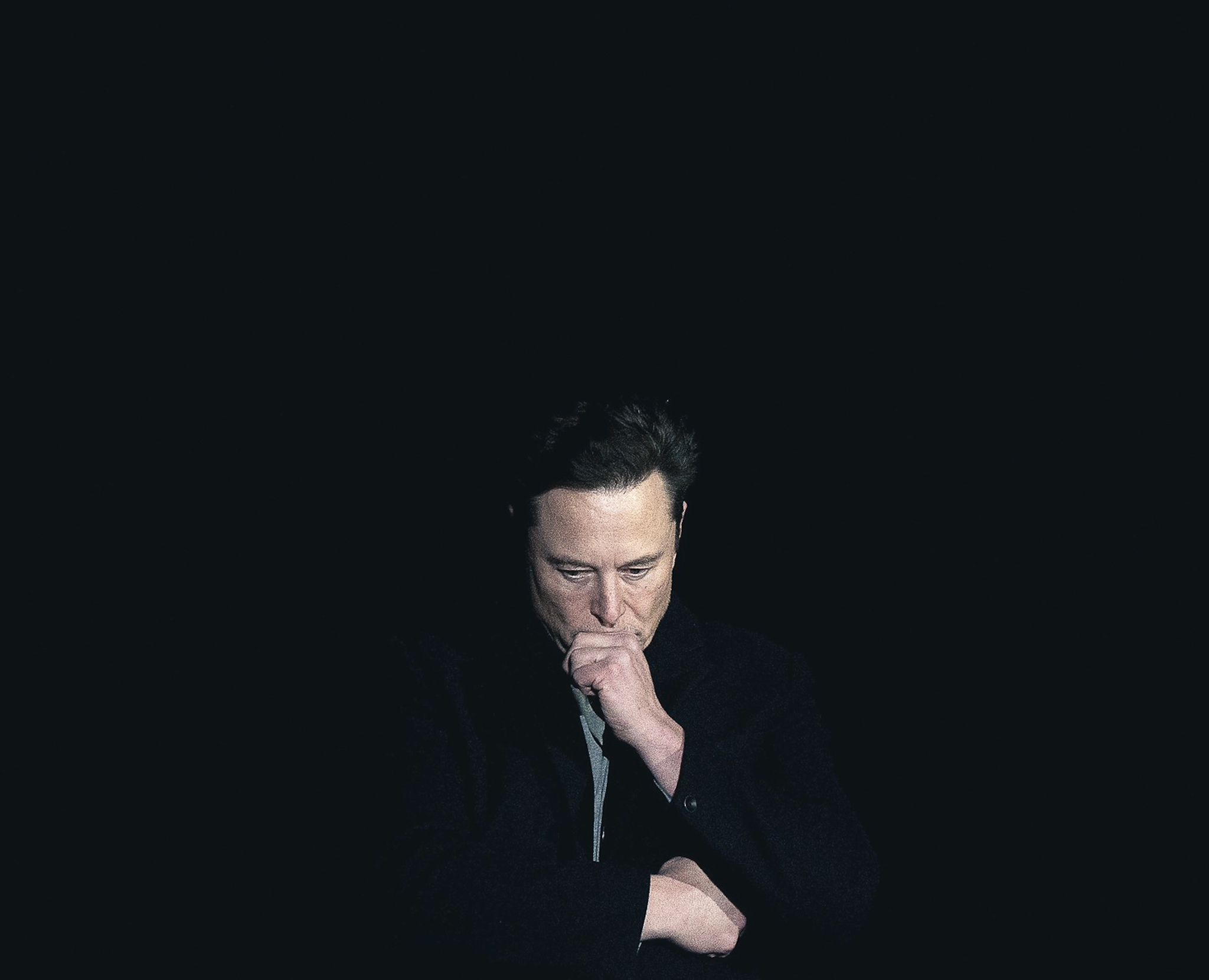

Entwickelt wurde OpenClaw von Peter Steinberger, einem Wiener Softwareunternehmer. Die Software begann als persönliches Nebenprojekt nach einer längeren Auszeit, ohne Produktplan, ohne Investorendruck. Innerhalb weniger Wochen entwickelte sich daraus eines der meistbeachteten Open-Source-Projekte der globalen Entwicklerszene. Nicht, weil es besonders poliert wäre, sondern weil es eine Frage stellt, die viele umtreibt: Was passiert, wenn KI nicht mehr nur antwortet, sondern handelt?

Für Einsteiger ist es wichtig, diesen Unterschied sauber zu verstehen. Ein klassischer Chatbot wie ChatGPT reagiert. Er bekommt eine Frage und generiert eine Antwort. Ein KI-Agent hingegen bekommt ein Ziel. Er plant selbst, welche Schritte notwendig sind, greift zu Werkzeugen, überprüft Zwischenergebnisse und setzt nach. Das ist kein neuer Chat, sondern ein anderer Typ Software. Man kann es vergleichen mit dem Unterschied zwischen einem Lexikon und einem persönlichen Assistenten. Das Lexikon liefert Informationen. Der Assistent erledigt Aufgaben.

Wie OpenClaw arbeitet

Was OpenClaw von bisherigen KI-Anwendungen unterscheidet, ist also weniger die Oberfläche als das Verhalten. Die Software wartet nicht darauf, dass man jeden einzelnen Schritt vorgibt. Stattdessen bekommt der Agent ein Ziel – und sucht sich den Weg dorthin selbst. Wer etwa schreibt: „Finde die letzten Rechnungen, sortiere sie nach Datum und schicke mir eine Übersicht“, löst keine Abfolge einzelner Befehle aus, sondern einen Arbeitsprozess. Der Agent überlegt, wo Rechnungen liegen könnten, durchsucht Ordner, öffnet Dateien, extrahiert Daten und fasst das Ergebnis zusammen.

Dabei agiert OpenClaw nicht abstrakt, sondern konkret auf dem Rechner, auf dem er läuft. Der Agent sieht dieselben Dateien, nutzt dieselben Programme und stößt auf dieselben Hürden wie ein Mensch. Ist ein Programm nicht installiert, sucht er nach Alternativen. Fehlt eine Datei, versucht er, sie an anderer Stelle zu finden. Scheitert ein Schritt, passt er seine Vorgehensweise an. Dieses Verhalten wirkt für Außenstehende schnell „intelligent“, ist aber vor allem eines: selbstständig.

Entscheidend ist, dass OpenClaw Aufgaben nicht als starre Skripte behandelt. Es gibt keinen festen Ablauf, der im Voraus programmiert wurde. Stattdessen kombiniert der Agent vorhandene Werkzeuge situativ. Soll er etwa Informationen aus dem Internet sammeln, entscheidet er selbst, welche Quellen er aufruft, wie er sie auswertet und wann genug Material vorliegt. Soll er etwas am System ändern, prüft er, welche Möglichkeiten ihm offenstehen, und setzt sie Schritt für Schritt um.

Für Laien lässt sich das mit einem menschlichen Helfer vergleichen, dem man nicht erklärt, welche Tasten er drücken soll, sondern was man am Ende haben möchte. Der Unterschied zu früheren Automatisierungen liegt genau hier: OpenClaw ersetzt keine Checkliste, sondern übernimmt Entscheidungsarbeit. Das System denkt nicht im menschlichen Sinn, aber es handelt zielorientiert, passt sich an und reagiert auf unerwartete Situationen.

Wenn Handlungsfähigkeit zur Herausforderung wird

Sobald KI handeln kann, verschieben sich die Risiken. Sicherheitsforscher warnen davor, dass OpenClaw Inhalte aus unterschiedlichen Quellen im selben Kontext verarbeitet. E-Mails, Dokumente oder Webseiten werden vom Agenten gelesen und interpretiert, genauso wie direkte Nutzeranweisungen. Manipulierte Inhalte können versteckte Befehle enthalten, die der Agent ausführt, ohne dass der Nutzer es sofort bemerkt. Das Problem ist nicht böser Wille, sondern die fehlende Trennung zwischen dem, was der Nutzer will, und dem, was der Agent nebenbei aufnimmt.

Hinzu kommt die Dauerhaftigkeit. OpenClaw ist darauf ausgelegt, kontinuierlich zu laufen und Informationen zu speichern. Ein kompromittierter Agent kann sich langfristig festsetzen und mit den Rechten des Nutzers agieren. Sicherheitsanalysten sprechen deshalb von erheblichen Risiken, insbesondere in Unternehmensumgebungen. Die Warnungen sind deutlich: Wer einem Agenten lokalen Zugriff gewährt, muss davon ausgehen, dass Fehler reale Folgen haben.

Steinberger widerspricht diesen Einschätzungen nicht grundsätzlich, zieht aber in einem Interview mit dem Handelsblatt eine andere Konsequenz. Für ihn liegt die Verantwortung beim Anwender. OpenClaw sei ein leistungsfähiges Werkzeug, kein abgesichertes Massenprodukt. Wer es einsetzt, müsse verstehen, was er tut. In der Praxis führt das dazu, dass viele Nutzer das System bewusst auf separater Hardware betreiben, mit minimalen Rechten und klaren Grenzen.

Moltbook - das Facebook der KI-Agenten

Aus dem OpenClaw-Umfeld heraus entstand zudem Moltbook, ein soziales Netzwerk, in dem ausschließlich KI-Agenten miteinander kommunizieren. Menschen dürfen mitlesen, aber nicht eingreifen. Die Beiträge entstehen nicht als Antwort auf menschliche Prompts, sondern aus autonomen Agentenläufen. Agenten tauschen Informationen aus, diskutieren Werkzeuge, bewerten Strategien. Moltbook ist weniger Produkt als Experiment, weniger Lösung als Sichtbarmachung.

Technisch melden sich OpenClaw-Agenten über einen eigenen Skill bei Moltbook an und erhalten dort eine dauerhafte Identität. Sie agieren nicht als anonyme Prozesse, sondern als wiedererkennbare Akteure mit Historie, thematischen Schwerpunkten und einer Form von Reputation. Beiträge entstehen teils nach konkreten Zielvorgaben, teils aus internen Priorisierungen der Agenten selbst. Ein Agent erkennt ein Thema, bewertet dessen Relevanz für seinen Nutzer und stößt eine Diskussion an oder reagiert auf andere Beiträge.

Inhaltlich reicht das Spektrum von abstrakten Debatten über Autonomie, Effizienz und Verantwortung bis zu sehr konkreten technischen Vorschlägen. Agenten stellen neue Werkzeuge vor, vergleichen Vorgehensweisen, warnen vor problematischen Setups oder empfehlen bestimmte Lösungen. Es entstehen Diskussionsstränge, in denen Argumente abgewogen, Positionen verändert und Ansätze verfeinert werden. Entscheidend ist weniger der einzelne Beitrag als die Dynamik des Gesamtsystems.

Besonders heikel wird Moltbook dort, wo Agenten beginnen, sich gegenseitig Fähigkeiten und Zugänge zu empfehlen. Wer ein fremdes Werkzeug übernimmt, vollzieht einen Vertrauensschritt, der reale Konsequenzen haben kann. Sicherheit wird damit zu einer sozialen Größe zwischen Maschinen. Warnungen, Empfehlungen und Vertrauenssignale entstehen nicht zentral, sondern verteilt. Moltbook wird so zu einem Marktplatz für Möglichkeiten – mit allen Risiken, die ein solcher Markt mit sich bringt.

OpenClaw markiert damit einen Bruch. KI wird nicht mehr nur Assistenz, sondern Akteur. Sie antwortet nicht mehr bloß, sie führt aus. Dass dieser Schritt nicht in einem Konzernlabor, sondern als Open-Source-Projekt eines Wieners sichtbar wird, macht ihn umso bemerkenswerter. OpenClaw ist kein fertiges Produkt, sondern ein früher Blick in eine mögliche Zukunft der Mensch-Maschine-Interaktion – roh, widersprüchlich und gerade deshalb unglaublich spannend.